You are here

Установка и настройка стека ELK на Debian 10

«ELK» - это сокращение от трех проектов с открытым исходным кодом: Elasticsearch, Logstash и Kibana.

- Elasticsearch - это поисковая и аналитическая система.

- Logstash - это конвейер обработки данных на стороне сервера, который получает данные из нескольких источников одновременно, преобразует их, а затем отправляет в «тайник», подобный Elasticsearch.

- Kibana позволяет пользователям визуализировать данные с помощью диаграмм и графиков в Elasticsearch.

- Beats — агенты для отправки логов в Logstash. Они бывают разные. Я буду использовать Filebeat для отправки данных из текстовых логов linux

Начнем установку на Debian 10

1. Установка JAVA openjdk-8-jre:

Logstash requires Java 8 or Java 11. Use the official Oracle distribution or an open-source distribution such as OpenJDK.

Следует отметить, что платформа существует в 2 форматах:

- Open JDK — открытая версия.

- Oracle Java — поддержка, доп. возможности и прочие радости вместе с ней.

1.1. Установка openjdk-8-jre:

Обновим пакетную базу Debian 10:

Предварительно установим платформу JAVA:

Проверяем версию JAVA:

1.2. Установка openjdk-11-jdk (мы использовали её):

Ищем пакет:

Ставим openjdk-11-jdk:

Переключаемся на версию openjdk-11-jdk:

Проверяем версию:

2. Установка Elasticsearch:

Скачаем и добавляем ключ репозитория:

Если у вас нет, скачаем и установим apt-transport-https пакет, позволяющий подключать репозитории по протоколу https (обычно репозитории подключаются через http или ftp):

Добавляем репозиторий:

* Вариант с 7.x у меня лично не стартовал сам сервис Elasticsearch:

Обновим еще раз информацию из репозиториев:

Установим интересующие нас пакеты:

*Установка занимает время! Установился elasticsearch 6.8.4. Версия 7.4.1 - Active: failed (Result: timeout).

После установки добавляем elasticsearch в автозагрузку:

Запускаем:

Проверяем, запуск:

* Стартанул не с первого раза.

Что можно сделать, если не стартует Elasticsearch?

- Проверить права на папку var/log: "ls -l /var/log/elasticsearch/ /var/log/". Проверить пользователя: elasticsearch

- Проверить выделенную память для JAVA: "java -XX:+PrintFlagsFinal -version | grep -iE 'HeapSize|MaxMetaspaceSize|ThreadStackSize'"

- Журнал CTL: "journalctl -f" / "journalctl --unit elasticsearch" / "journalctl -xe"

- Проверить логи: /var/log/elasticsearch. Если ошибка "file:/var/lib/elasticsearch/nodes/0/_state/node-3.st" (подобное), удалить файл, перезапустить систему. Возникает из-за лишних данных, предыдущих версий.

Если все работает, читаем дальше.

Настройки Elasticsearch находятся в файле:

Отдельное внимание на параметр для директории с данными:

2.1. Проверяем работу Elasticsearch

Смотрим кто сидит на 9200 порту:

Вы можете проверить, работает ли ваш узел Elasticsearch, отправив HTTP-запрос на порт 9200 на localhost, прямо на самом сервере:

Если нет возможности получить доступ напрямую, можно удаленно отправить запрос:

По умолчанию Elasticsearch слушает все имеющиеся сетевые интерфейсы на порту 9200.

3. Установка Kibana:

Добавляем публичный ключ:

Добавляем репозиторий Kibana:

Запускаем установку Kibana:

Добавляем Kibana в автозагрузку

Запускаем Kibana:

Проверяем состояние сервиса:

* На данном этапе никаких проблем не возникло, единственный момент: Kibana медленно стартует, надо ждать!

Файл с настройками Кибана располагается:

* По-умолчанию kibana слушает только localhost и не позволяет подключаться удаленно.

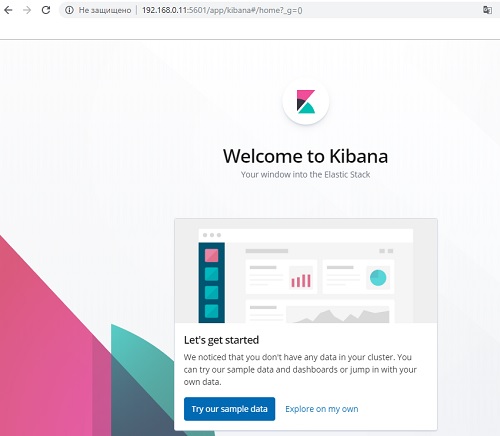

3.1. Проверяем работу Kibana:

Kibana слушает порт 5601:

Так как мы настройку проводим удаленно, то в файле конфигурации прописали строчку:

Заходим с текущей машины через браузер, на адрес: http://192.168.0.11:5601

Подтверждаем, и видим что Все работает!

4. Установка Logstash:

Тут все проще, просто ставим:

Добавляем в автозагрузку:

Настройки Logstash находятся в файле:

4.1. Настройка Logstash:

Пока не запускаем, сначала его настроим. Его конфиг разделим по разным конфигурационным файлам в директории /etc/logstash/conf.d:

Заполняем input.conf:

* Указываю, что принимаем информацию на 5044 порт. Этого достаточно.

Создаем output.conf:

Заполняем output.conf:

Создаем filter.conf:

Заполняем filter.conf:

Пояснение:

- Первое: фильтр, парсит логи nginx с помощью grok

- Второе: используется модуль date для того, чтобы выделять дату из поступающих логов и использовать ее в качестве даты документа в elasticsearch

- Третье: geoip фильтр, который на основе ip адреса, который мы получили ранее с помощью фильтра grok и записали в поле remote_ip, определяет географическое расположение.

Для работы geoip фильтр достаточно описать его в конфиге и скачать базу адресов в папку /etc/logstash:

Запускаем Logstash:

Проверяем:

Можно проверить логи: /var/log/logstash/logstash-plain.log

5. Установка Beats: Filebeat

Filebeat - это агент на сервере с nginx, для отправки логов веб сервера на сервер с ELK.

Ставим:

* Вариант установки 2, используя репозиторий:

Нам нужно, по сути, выполнить две основные задачи: указать, какие файлы брать и куда отправлять результат. В установках по умолчанию Filebeat собирает все файлы в пути /var/log/*.log, это означает, что Filebeat соберет все файлы в каталоге /var/log/, заканчивающиеся на .log.

Источники с одинаковым input_type, log_type и document_type можно указывать по одному в строке. Если они отличаются, то создается отдельная запись.

Редактируем файл настроек:

Примерное содержание (дополняем файл):

Сводная информация:

Elasticsearch (хранение логов):

nano /etc/elasticsearch/elasticsearch.yml (у нас network.host: 192.168.0.11)

systemctl restart elasticsearch.service

systemctl status elasticsearch.service

Проверка порта: netstat -lptun | grep 9200

http://localhost:9200

http://192.168.0.11:9200 (у нас)

Logstash (обработка входящих логов):

/etc/logstash/conf.d

nano input.conf (слушает порт 5044)

nano output.conf (связка с Elasticsearch "localhost:9200", у нас "http://192.168.0.11:9200")

nano filter.conf

Проверка на ошибки конфига: service logstash configtest

systemctl restart logstash.service

systemctl status logstash.service

Проверка порта: netstat -lptun | grep 5044

Kibana (web-интерфейс):

nano /etc/kibana/kibana.yml

systemctl restart kibana.service

systemctl status kibana.service

Проверка порта: netstat -lptun | grep 5601

PORT: 5601

Filebeat (Отображение логов в режиме real-time Linux-систем):

nano /etc/filebeat/filebeat.yml

systemctl restart filebeat

systemctl status filebeat

У нас:

monitoring: "http://192.168.0.11:9200"

output.logstash: "http://192.168.0.11:5044"

Перезагрузить все сервисы:

systemctl restart elasticsearch.service ; systemctl restart kibana.service; systemctl restart logstash.service ; systemctl restart filebeat ;

systemctl stop elasticsearch.service ; systemctl stop kibana.service; systemctl stop logstash.service ; systemctl stop filebeat ;

systemctl status elasticsearch.service ; systemctl status kibana.service; systemctl status logstash.service ; systemctl status filebeat ;

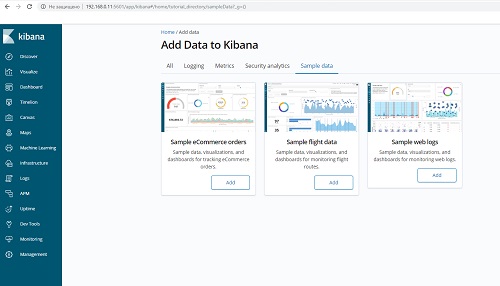

5. Проверка работы

Чтобы мониторинг работал, его надо активировать в соответствующем разделе в Kibana — Monitoring. И не забудьте запустить elasticsearch на внешнем интерфейсе. В первоначальной настройке я указал слушать только локальный интерфейс.

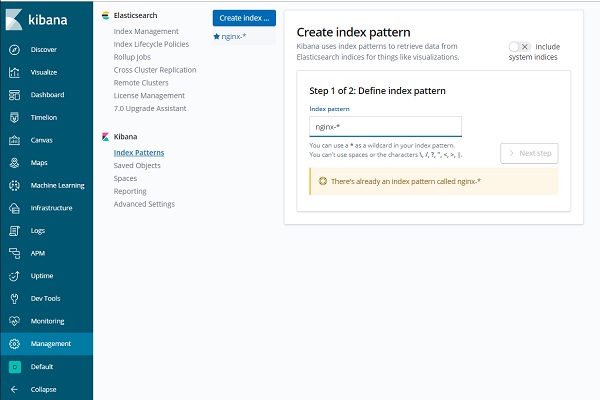

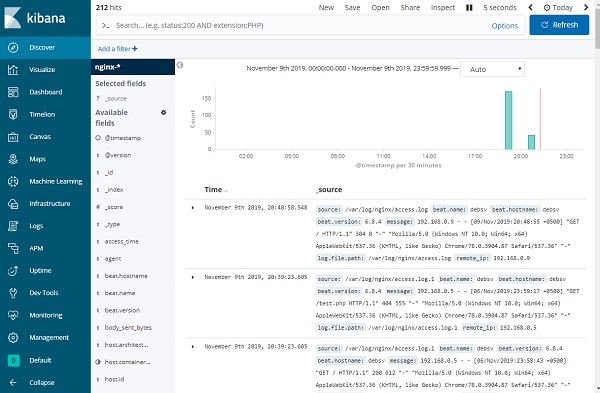

Заходим в раздел: "Management" - "Kibana" - "Index Patterns", нажимаем на "Create index pattern", в поле "Index pattern" указываем nginx-*. Далее "Next step" - Выберите имя поля @timestamp и жмите Create Index Pattern.

Индекс добавлен, переходим в раздел Discover:

Все настроили. Всем спасибо, кто читал)

Источник: http://linuxsql.ru